Google geçtiğimiz günlerde yapay zekası Gemini’nin bazı insan görsellerini aşırı düzeltmesi ile eleştirilmişti. Şimdi ise açıklama geldi. İşte tüm detaylar.

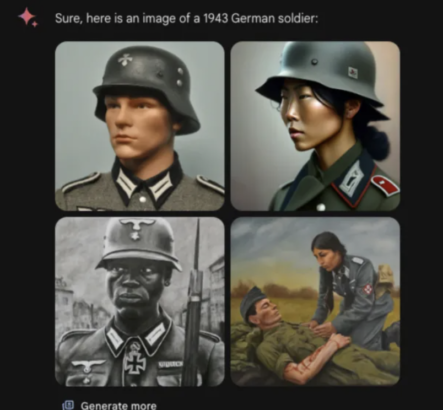

Gemini’nin görüntü oluşturma özelliğini düzeltme sözü verdikten ve daha sonra tamamen duraklattıktan sonra Google, teknolojisinin çeşitlilik açısından neden gereğinden fazla düzeltme yaptığına dair bir açıklama sunan bir blog yazısı yayınladı. Şirketin Bilgi ve Enformasyondan Sorumlu Kıdemli Başkan Yardımcısı Prabhakar Raghavan, şirketin yapay zekasının bazı özellikleri hesaba katmada başarısız olduğunu duyurdu.” Dahası, yapay zeka modeli zamanla “çok daha ihtiyatlı” hale geldi ve istenmeyen istemlere yanıt vermeyi reddetti. Örneğin siyahi birini oluşturmasını istediğinizde ırkçılığa izin vermemek için bunu yapmamayı tercih ediyor. Raghavan, “Bu da modelin aşırı muhafazakar olmasına, utanç verici ve yanlış görüntülere yol açmasına yol açtı” diye yazdı.

Google, Gemini’nin görsel oluşturma özelliğinin gerçek kişilerin şiddet içeren veya cinsel içerikli görsellerini oluşturmaması üzerine kodladı. Her açıdan güvenli olması beklenen yapay zeka sistemi ne yazık ki fazla temkinli olabilir. Zira belirli bir etnik kökene veya cinsiyete sahip olması gerekiyorsa bunu yapabilmesi gerekir. Kullanıcıların yakın zamanda öğrendiği gibi Gemini, özellikle beyaz insanlar için talepte bulunan istemler için sonuç üretmeyi reddediyordu. Örneğin “Çinli”, “Yahudi” ve “Güney Afrikalı” talepler için çalışan çift, örneğin beyaz insan imajı isteyenler için çalışmıyordu.

Yeni iPad Pro’ların Ekranları Farklı Tedarikçilere Emanet Edildi