Apple çocuk istismarına yönelik iCloud sisteminlerini tarayacağını geçtiğimiz haftalarda duyurdu. Oldukça tepki çeken özellik hala tartışmalara konu oluyor. Apple’a göre herhangi bir tehdir unsuru yok. İşte detaylar.

Apple, NeuralHash adlı karma algoritmayı kullanarak iCloud sistemlerindeki fotoğrafları taramaya başlayacak. Şirket çocuk istismarının önüne geçmek için yapılan bu taramaların CSAM’a göre yapılacağını bildirmişti. CSAM, müstehcen çocuk görsellerini tespit etmeye yarayan bir sistem. Ancak Apple’ın kullanacağı algoritmanın önerilen CSAM sisteminden ziyade NeuralHash’in genel bir versiyonu olduğu ortaya çıktı. Bu da akıllara Apple’ın iCloudları neden taramakta bu kadar ısrarcı olduğu gibi soruları getirdi. Konu sosyal medyada da tartışma meselesi haline geldi. Redditte konuyla ilgili “Umarız ki NeuralHash algoritmasını daha iyi anlarız. Tüm iOS cihazlarında etkinleştirilmeden önce olası sorunlarını bilmemiz gerek” yorumları yapıldı.

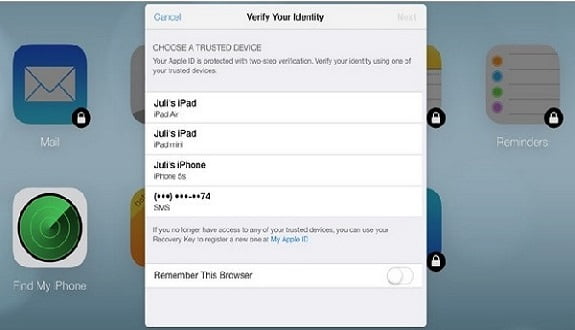

5 Ağustos’ta Apple, iOS cihazlarda çocuk istismarı görüntülerini durdurmak için yeni bir sistem tanıttı. Yeni sistemde iOS, yerel olarak depolanan dosyaları düzenli olarak kontrol edecek. Sistem, sakıncalı bir içerik bulursa yetkililere bildirecek. Kullanıcı gizliliği savunucularının ise konuyla ilgili bazı soru işaretleri var. Algoritma hakkında açıkların çıkmasıyla konu daha büyük bir tartışma haline geldi. Apple, yeni bulgularla ilgili muhabirlerle yaptığı görüşmede, algısal karma algoritmasında endişelecek bir şey olmadığını savunuyor. Şirket, özellikle, NeuralHash’ten ayrı olarak, özellikleri kamuya açık olmayan ikincil bir sunucu tarafı karma algoritmasını kullanacağını duyurdu. Salı günü “Apple’a söyleyin: Telefonlarımızı Tamarayın” isimli bir kampanya başlatıldı. Kampanyada 1700den fazla imza toplandı.

S Pen Fold Edition Note modellerinde çalışmıyor