Nvidia yeni sunucu teknolojisiyle rakiplerine adeta gözdağı verdi. Çinli Moonshot AI gibi yapay zeka modellerinde yüksek performans artışı sağlandı. Peki bu hızın arkasında ne yatıyor? Gelin birlikte bakalım…

Nvidia paylaştığı çarpıcı verilerle yine dikkatleri üzerine çekmeyi başardı. Şirketin yeni nesil yapay zeka sunucusu, aralarında popüler Çinli AI modellerinin de bulunduğu sistemlerin performansını artırdı. Dev firma pazar hakimiyetini modellerin yalnızca eğitimiyle (training) sınırlamak niyetinde değil. Yapay zeka araçlarının kullanıma sunulduğu aşamada da dizginleri eline almak istiyor. Ancak bu noktada AMD ve Cerebras gibi isimlerle kıyasıya bir pazar kapma yarışında.

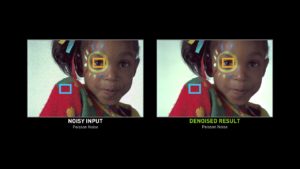

Söz konusu sunucu teknolojisi ‘Mixture of Experts/MoE’ mimarisine dayanıyor. Biraz daha açıklayıcı olursak; bir konuyu tek kişiye sormak yerine, konuyu parçalara bölüp farklı uzmanlara sormak gibi düşünebilirsiniz. Bu yöntem yapay zekanın çok daha verimli çalışmasına imkan tanıyor. Hatırlarsanız DeepSeek, 2025 başlarında R1 modeliyle sektörde tozu dumana katmıştı. İşte R1, MoE tekniğini popüler hale getirdi. O günden bu yana OpenAI, Mistral, Moonshot gibi şirketler MoE yaklaşımını benimsedi.

Nvidia resmen tilki gibi hareket ediyor. Modellerin eğitimi için daha az çip gücüne ihtiyaç duyulsa bile, bu modellerin kullanımında da Nvidia donanımlarının hâlen en iyi seçenek olduğunu kanıtlamaya çalışıyor. Şirket, 72 adet çipi tek bilgisayarda toplayıp, bunları süper hızlı bağlantılarla birbirine bağlayan yeni sunucusuna çok güveniyor. Bu sunucu Moonshot’ın Kimi K2 Thinking modelinin performansını önceki nesillere göre 10 kat yukarı taşıdı. Benzer bir sıçrama DeepSeek modellerinde de gözlemlendi. Aslında her şey sunucudaki yonga sayısının fazlalığı ve bu yongalar arasındaki veri akışının çok hızlı gerçekleşmesiyle mümkün oluyor.