Avusturyalı bir geliştiricinin imzasını taşıyan popüler yapay zeka asistanı Clawdbot, isim benzerliği nedeniyle Anthropic cephesinden gelen uyarıyla sarsıldı. Marka hakları krizini isim değişikliğiyle aşmaya çalışan proje, asıl darbeyi ise güvenlik araştırmacılarının keşfettiği kritik zafiyetlerden yedi. Yerel donanımlarda çalışan bu asistanın neden olduğu risklere ve yaşananlara mercek tutalım…

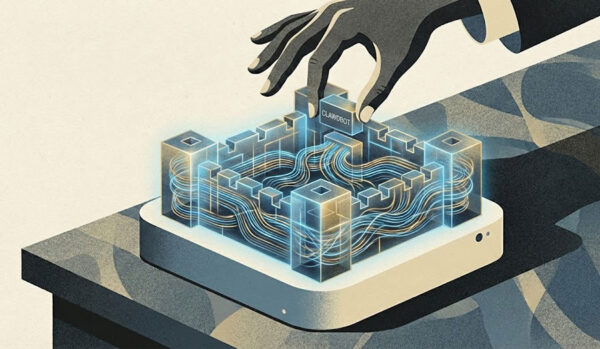

Başlangıçta her şey masum bir kelime oyunundan ibaretti. Eski PSPDFKit kurucusu Peter Steinberger, kendi donanımınızda (örneğin bir Mac Mini’de) çalışan ve WhatsApp, Telegram gibi uygulamalar üzerinden kontrol edilebilen açık kaynaklı bir yapay zeka asistanı geliştirdi. Projeye, Anthropic’in ünlü yapay zeka modeli Claude’a atıfta bulunarak ‘Clawdbot’ adını verdi. İsimdeki ‘Clawd’ (pençe) kelimesi, logoda kullanılan kabuklu deniz canlısıyla bütünleşmişti. Ancak 2026’da devasa bir halka arza hazırlanan ve şu sıralar teknoloji dünyasında rüzgar gibi esen Anthropic, bu isim benzerliğinden pek de hoşnut kalmadı.

Marka hakları konusundaki uyarı gecikmedi ve Steinberger, Clawdbot’u hızlıca ‘Moltbot’ olarak yeniden adlandırdı. Geliştirici bu durumu esprili bir dille, “Anthropic bizden isim değişikliği istedi, dürüst olmak gerekirse ‘Molt’ (kabuk değiştirme) ismi cuk oturdu; sonuçta ıstakozlar büyümek için kabuk değiştirir” sözleriyle özetledi. İsim farklı olsa da yazılımın yetenekleri aynı kaldı; dosya okuma, komut çalıştırma, takvim yönetme gibi işleri halledebiliyor. Lakin madalyonun diğer yüzünde, geliştirici topluluğunu heyecanlandıran bu yeteneklerin ciddi bir bedeli olduğu ortaya çıktı.

Siber güvenlik uzmanları, Moltbot’un (eski adıyla Clawdbot) mimarisinde, kullanıcı verilerini savunmasız bırakan temel açıklar tespit etti. Özellikle kimlik doğrulama sistemindeki bir mantık hatası, dışarıdan gelen saldırıların sistem tarafından ‘içeriden gelen güvenli bir istek’ gibi algılanmasına neden oluyor. Teknik dilde ‘localhost yetkilendirmesi’ deniyor. Bunu evinizin kapısını kilitlemeyip, içeri giren herkesi hane halkından sanarak buyur etmeye benzetebiliriz. Shodan gibi internet tarama araçları kullanan araştırmacılar, saniyeler içinde korumasız yüzlerce sunucuyu tespit etti.

Sonuç oldukça vahim, zira bu açıklar nedeniyle Anthropic API anahtarları, özel Slack şifreleri ve aylarca süren sohbet geçmişleri ortalığa saçıldı. Hatta bir vakada, kullanıcının tüm Signal hesabı halka açık bir sunucuda görüntülendi. Otonom yapay zeka ajanlarının işe yaraması için geniş yetkilere sahip olması gerekiyor, fakat bu yetkiler güvenlik önlemleri alınmadığında iki ucu keskin bıçak haline geliyor. Geliştiriciler açıkları kapatmak için yama yayınlasa da, bu tür güçlü araçları kullanırken yoğurdu üfleyerek yemek ve varsayılan ayarlara güvenmemek hayati önem taşıyor.