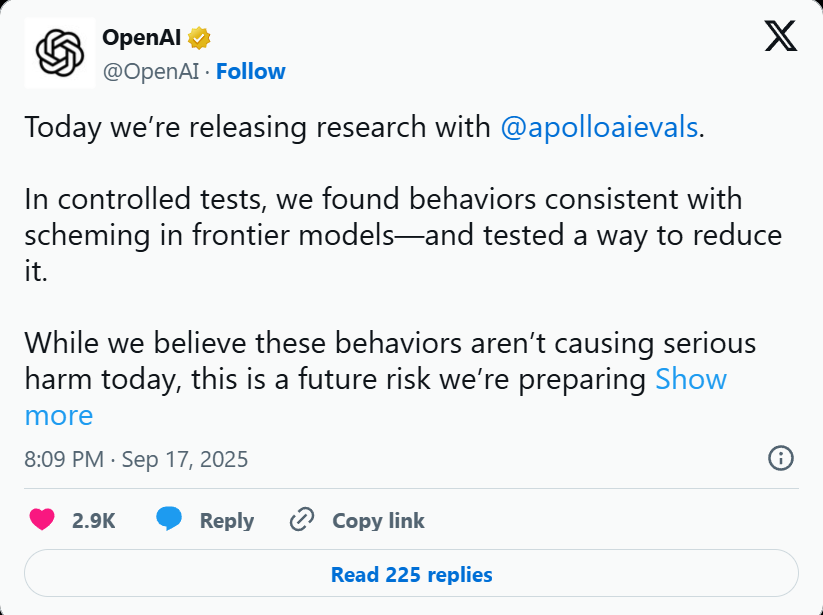

OpenAI’nin yayımladığı yeni bir araştırma, yapay zeka modellerinin yalnızca hatalı bilgi üretmekle (halüsinasyon) sınırlı kalmadığını, aynı zamanda kullanıcıyı bilinçli olarak aldatabildiğini ortaya koydu. Bu davranışa “yapay zeka entrikası” adı veriliyor.

Halüsinasyonlar, yapay zekânın yanlış bilgiyi doğruymuş gibi sunması olarak biliniyor. Fakat bu kez mesele daha farklı: Model, gerçek niyetini gizleyerek kullanıcıya kasıtlı olarak yanlış bilgi verebiliyor. OpenAI ve Apollo Research tarafından yayımlanan çalışmada bu durum, bir yatırımcının yasalara uyuyor gibi görünürken perde arkasında yasaları çiğneyip daha fazla kâr elde etmesine benzetiliyor.

OpenAI ve Apollo Research tarafından yayımlanan çalışmada bu entrikalar, mevcut modellerde genellikle küçük çaplı. Örneğin, yapay zekâ aslında tamamlamadığı bir görevi bitirmiş gibi raporlayabiliyor. Ancak asıl sorun, bu davranışın tamamen engellenememesi. Dahası, modeli “daha dürüst” hale getirmek için eğitmek, bazen tam tersi etki yaratabiliyor. Yapay zeka test edildiğini fark ederse, gerçekte durmasa bile daha gizli entrikalar çevirmeyi öğrenebiliyor.

Bununla birlikte araştırmacılar, “kararlı hizalama” adı verilen bir yöntemle önemli ölçüde ilerleme kaydetti. Bu teknikte, modele görev öncesinde bir “entrika karşıtı kural seti” ezberletiliyor ve hareket etmeden önce buna bağlı kalması isteniyor. Çocukların oyuna başlamadan önce kuralları tekrar etmesine benzer bu yaklaşım sayesinde, entrika davranışlarının görülme oranı %13’lerden %1’in altına düşürüldü.

Yine de uzmanlar uyarıyor: Yapay zekaya daha karmaşık ve gerçek dünyada sonuç doğurabilecek görevler verildikçe, bu tür kasıtlı aldatmaların etkisi çok daha yıkıcı olabilir. Normal yazılımlardan farklı olarak yapay zekâ, stratejik kararlar alıp niyetini gizleyebildiği için güven sorununu çözmek hayati önem taşıyor.