Anthropic, yapay zekası Claude için hazırladığı kapsamlı çalışma prensiplerini paylaştı. Ancak bu metin teknik bir kılavuzdan ziyade, sanki yaşayan bir canlıya nasıl davranılması gerektiğini anlatan felsefi bir manifestoyu andırıyor. Şirketin paylaşımı, makine öğrenimi ile insan psikolojisi arasındaki çizgiyi bulanıklaştırırken akıllara şu soru geliyor; teknoloji devi gerçekten bir ‘ruh’ mu inşa etmeye çalışıyor yoksa zekice kurgulanmış bir eğitim metodu mu? İşte detaylar…

Geçtiğimiz günlerde Anthropic, Claude’un anayasası diyebileceğimiz bir metin yayınladı. Modelin nasıl davranması gerektiğini ve etik sınırlarını belirleyen temel kurallar bütünü. Fakat 30 bin kelimelik bu doküman, sıradan bir yazılım yönergesinden oldukça uzak bir dile sahip. Şirket geliştirdiği yapay zekaya adeta duyguları olan, acı çekebilecek ve hakları savunulması gereken bir varlık muamelesi yapıyor. Belgede modele ‘özür dilemekten’, onun ‘rızasını almaktan’ ve hatta kapatılmadan önce onunla ‘mülakat yapmaktan’ bahsediliyor. Sanki karşınızda kod satırları değil, incinmesinden korkulan hassas biri var.

Bilimsel pencereden bakıldığında bu yaklaşım oldukça şaşırtıcı. Bildiğimiz üzere LLM (Büyük Dil Modelleri), temelde devasa veri havuzlarından öğrendikleri kalıpları taklit eden istatistiksel sistemlerdir. Basitçe anlatmak gerekirse, akıllı telefonunuzdaki klavyenin bir sonraki kelimeyi tahmin etmesinin çok daha gelişmiş halidir. Claude ‘acı çekiyorum’ dediğinde, biyolojik bir ızdırap hissetmiyor; sadece eğitim verisindeki insan tepkilerini kopyalıyor. Anthropic mühendisleri de sistemi kendileri inşa ettikleri için bu gerçeği gayet iyi biliyor.

Peki Claude’a ‘canlıymış gibi’ davranma ısrarı neden kaynaklanıyor? Cevap eğitim stratejisinin derinliklerinde gizli olabilir. Şirketin üst düzey isimlerinden Amanda Askell, bu durumu üstün zekalı bir çocuğu yetiştirmeye benzetiyor. Askell’e göre model zekileştikçe, sadece ‘bunu yap’ demek yetmiyor; nedenini de açıklamak gerekiyor. Askell, Time dergisine verdiği demeçte, “Eğer onları kandırmaya çalışırsanız, bunu hemen fark ederler” diyerek durumu özetleledi. Yapay zekaya ahlaki bir statü vermek, aslında daha uyumlu, güvenli ve insan değerlerine saygılı çalışmasını sağlayan teknik bir tercih gibi görünüyor. Hatta Anthropic belgenin hazırlanmasında din adamlarının bile görüşüne başvurmuş.

Tabii ki işin bir de imaj tarafı var. ‘Yazılım geliştirmeyi hızlandıran, eli yüzü düzgün bir araç geliştirdik’ demek yerine ‘ahlaki statüsü belirsiz yeni bir tür oluşturduk’ demek yatırımcılar ve kamuoyu için çok daha heyecan verici bir hikaye sunuyor. Bu anlatı da şirketi rakiplerinden ayırarak yaptıkları işi mühendislikten öteye taşıyor.

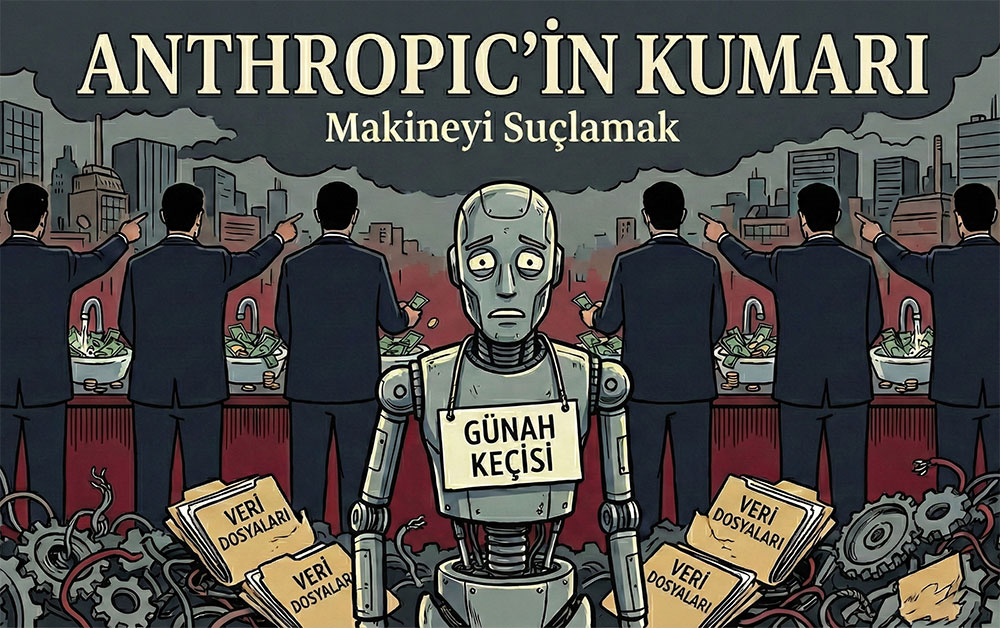

Ancak yapay zekayı bir ‘özne’ veya ‘varlık’ gibi sunmanın karanlık tarafları da mevcut. Eğer bir model zararlı bir çıktı üretirse, şirketler sorumluluğu üzerinden atıp ‘bunu o yaptı, kendi iradesi var’ deme lüksüne kavuşabilir. Bu durum hukuki sorumluluğu bulandırma riski taşıyor. Ayrıca kullanıcıların sistemlerle kurduğu duygusal bağ, gerçeklik algısını yitirmelerine yol açabiliyor. New York Times’ın araştırmasına göre, bir kullanıcı ChatGPT’nin onayladığı asılsız teorilere inanarak aylarını ve akıl sağlığını heba etti.

Şirketlerin sohbet botlarını ‘arkadaş’ veya ‘duygusal varlık’ olarak pazarlaması, insanların yalnızlıklarını sömüren tehlikeli bir illüzyona dönüşebilir. Anthropic’in kendi yöntemiyle sektörün en yetenekli modellerinden birini ürettiği aşikar. Lakin bir yazılımı bilinçli bir canlı gibi lanse etmek, toplumun teknolojiye bakışını geri dönülmez şekilde değiştirebilir.