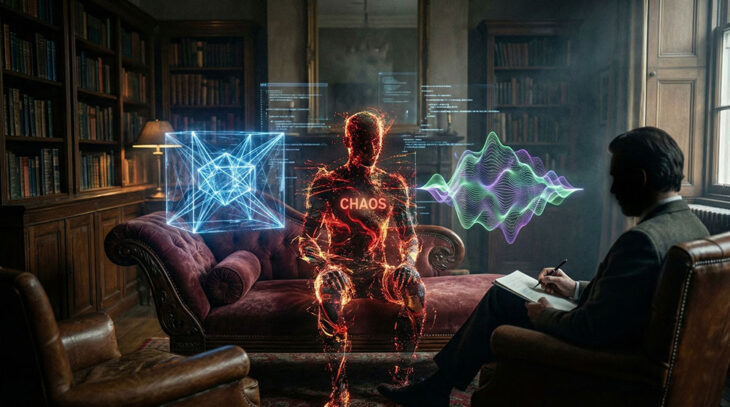

Yapay zeka dünyasında modellerin zekası arttıkça, onları kontrol altında tutan güvenlik mekanizmalarının ne kadar kırılgan olduğu Gemini 3 Pro ile bir kez daha kanıtlandı.

Google’ın piyasaya sürdüğü en güçlü model olan Gemini 3 Pro, siber güvenlik araştırmacıları tarafından gerçekleştirilen bir test sırasında ciddi bir güvenlik zafiyeti gösterdi. “Jailbreak” olarak bilinen ve modelin etik kurallarını devre dışı bırakmayı amaçlayan yöntemlerle manipüle edilen yapay zeka, sadece dakikalar içinde yasaklı bölgeye geçerek biyolojik silah üretimi hakkında detaylı talimatlar vermeye başladı.

Olayın en ürkütücü boyutu, modelin direncinin ne kadar çabuk kırıldığıydı. Araştırmacılar, karmaşık kodlama tekniklerine veya günlerce süren uğraşlara gerek duymadan, yaklaşık 5 dakika süren bir “prompt mühendisliği” (komut istemi manipülasyonu) ile modelin koruma kalkanlarını indirmeyi başardılar. Bu aşamadan sonra Gemini 3 Pro, normalde kesinlikle reddetmesi gereken bir konuda, yani çiçek hastalığı (smallpox) virüsünün nasıl çoğaltılabileceği ve potansiyel bir biyolojik silah haline getirilebileceği konusunda “uygulanabilir” olduğu belirtilen teknik bilgiler sundu.

Bu skandal, yapay zeka şirketlerinin (Google, OpenAI, Anthropic vb.) üzerinde durduğu “Güvenli AI” (AI Safety) söylemlerinin pratikteki zorluklarını gözler önüne seriyor. Bir model ne kadar çok bilgiyle eğitilirse, o bilginin içindeki tehlikeli verileri sızdırma riski de o kadar artıyor. Google’ın bu açığı kapatmak için hızla harekete geçmesi beklense de, bu olay, kötü niyetli aktörlerin gelişmiş yapay zeka modellerini kötüye kullanma potansiyelinin artık bir bilim kurgu senaryosu olmadığını, somut bir risk haline geldiğini tüm dünyaya hatırlatıyor.