Analog saat okumak insan için kolay, yapay zeka için zor oldu. ClockBench testinde AI modelleri sınıfta kaldı. İşte detaylar…

Sınıfın çalışkan öğrencisi kıvamına gelen yapay zeka modelleri, ClockBench isimli yeni bir sınava daha girdi. Bu benchmark analog saatleri okumaya odaklanıyor. İnsan için basit olan bu görev, modelleri bir hayli zorladı. Veri setinde 36 farklı saat yüzü ve toplam 180 saat görseli var. Her saat için dört ayrı soru hazırlandı. Böylece 720 soruluk bir test ortaya çıktı. Görevler arasında yalnızca saati okumak değil; üzerine süre eklemek, ibreleri çevirmek ve farklı şehirlerin saatine uyarlamak da bulunuyor.

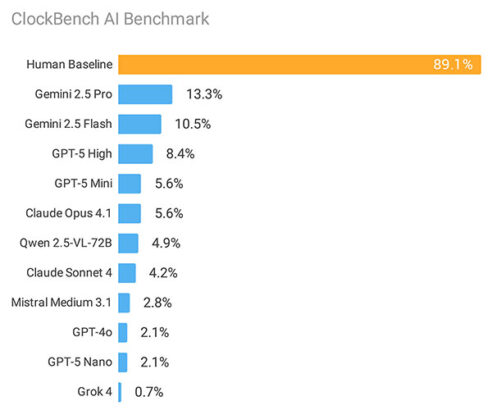

Sonuçlar oldukça çarpıcı. Beş yetişkin katılımcı %89.1 doğruluk oranına ulaştı. Modellerin en iyisi bile bu seviyeye yaklaşamadı. Gemini 2.5 Pro yalnızca %13.3 başarı elde etti. Diğer modeller de benzer şekilde başarısız oldu. Gemini 2.5 Pro’nun arkasından %10.5 oranla Gemini 2.5 Flash ve %8.4’le GPT-5 High geliyor.

Yanlış cevaplarda tablo daha da dikkat çekici. İnsanlar hatayı ortalama 3 dakikayla yaptı. Modellerin ortalama sapması 2 ila 3 saat arasında değişti. Bu da çoğu durumda tahminin rastgeleye yakın olduğunu gösteriyor. Benchmark’ın zorlayıcı kısımları Roma rakamları, saniye ibresi, renkli arka planlar ve 24 saat formatı oldu. Buna karşılık, basit beyaz veya siyah kadran, tek ibre ve büyük rakamlı saatlerde yapay zeka araçları biraz daha iyi sonuç verdi.

Aslında şöyle bir durum var; AI modelleri saati doğru okuduğunda süre eklemek, ibreleri çevirmek, farklı şehirlerin saatine uyarlamak gibi testleri yüksek doğrulukla yapıyor. Yani sorun hesaplamada değil, saati görsel olarak tanımaktan kaynaklanıyor.

Yapay zeka sistemleri bilgi yoğun sınavlarda, matematiksel denklemlerde ya da karmaşık mantık zincirlerinde hızla ilerliyor. Fakat sıra basit bir analog saati okumaya geldiğinde tökezliyorlar. Çocuk yaşta öğretilen bu beceri makineler için büyük bir engel. Bu da görsel çözümlemenin, metinsel akıl yürütmeden çok daha zor bir eşik olduğunu gösteriyor.